Internet, Cloud computing, IoT (objets connectés)… L’écosystème digital fait exploser les volumes d’informations numériques (Big Data) dont l’accumulation pèse sur les data centers. L’enjeu du stockage s’amplifie de jour en jour. Mais, en 2025, impossible de ne pas compter sur l’IA pour résoudre cette problématique contemporaine. L’intelligence artificielle est désormais au service de la compression des données. Succinct état des lieux des avancées en la matière.

Les avancées de l’IA dans la compression

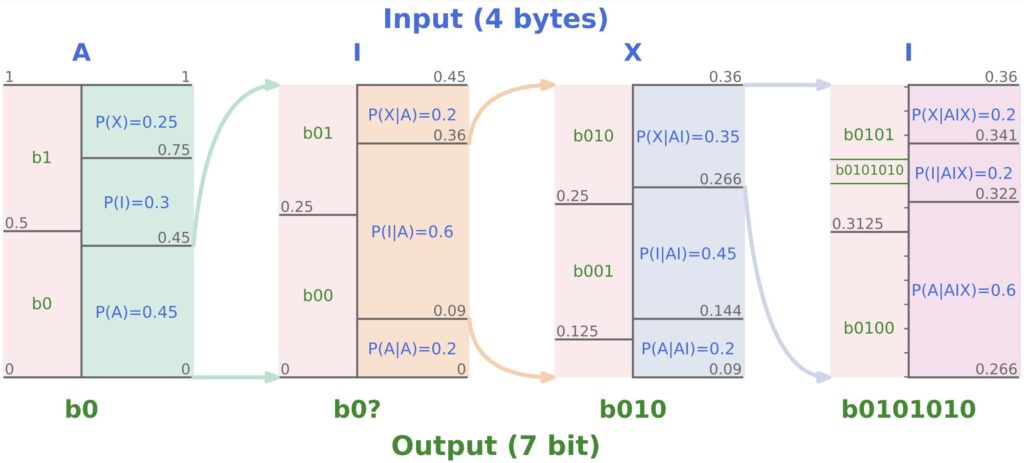

Depuis longtemps, les chercheurs ont observé le lien entre les modèles prédictifs et la compression de données. De fait, les modèles de langage peuvent aussi représenter les données sous une forme plus compacte grâce à des principes clé de la compression comme :

- l’analyse des données ;

- la réorganisation et l’optimisation des données ;

- la prédiction et la réduction de la redondance, etc.

Chinchilla

DeepMind (la branche spécialisée dans l’intelligence artificielle de Google) a démontré la similarité de ces fonctionnements lors d’essais de compression par l’IA. Ils ont aussi pu prouver que cette dernière surpasse les logiciels existants. Le modèle Chinchilla 70B peut, par exemple, compresser des images à 43,4 % de leur taille initiale et des fichiers audio à 16,4 %. Ce qui est mieux que certains compresseurs classiques et bien sûr, sans subir de perte de données !

NVIDIA

Dans le domaine du gaming, le poids est un enjeu qui pèse. Les jeux ultra-réalistes sont aussi ultra-lourds ! Pour résoudre ce problème, le fabricant de cartes graphiques NVIDIA, dope ses produits à l’IA. Ses technologies RTX font ainsi entrer en convergence réseaux neuronaux et graphisme :

- RTX Neural Texture Compression : réduit le poids des textures de 80 % de plus que les technologies actuelles.

- RTX Neural Materials : compresse le rendu des matériaux et diminue l’usage de la mémoire vive.

Ce qui est impressionnant dans cette technologie, c’est qu’au-delà de la compression, elle améliore le réalisme des scènes ! Mais, a priori, cela se fait au détriment des performances du jeu… On ne peut pas tout avoir !

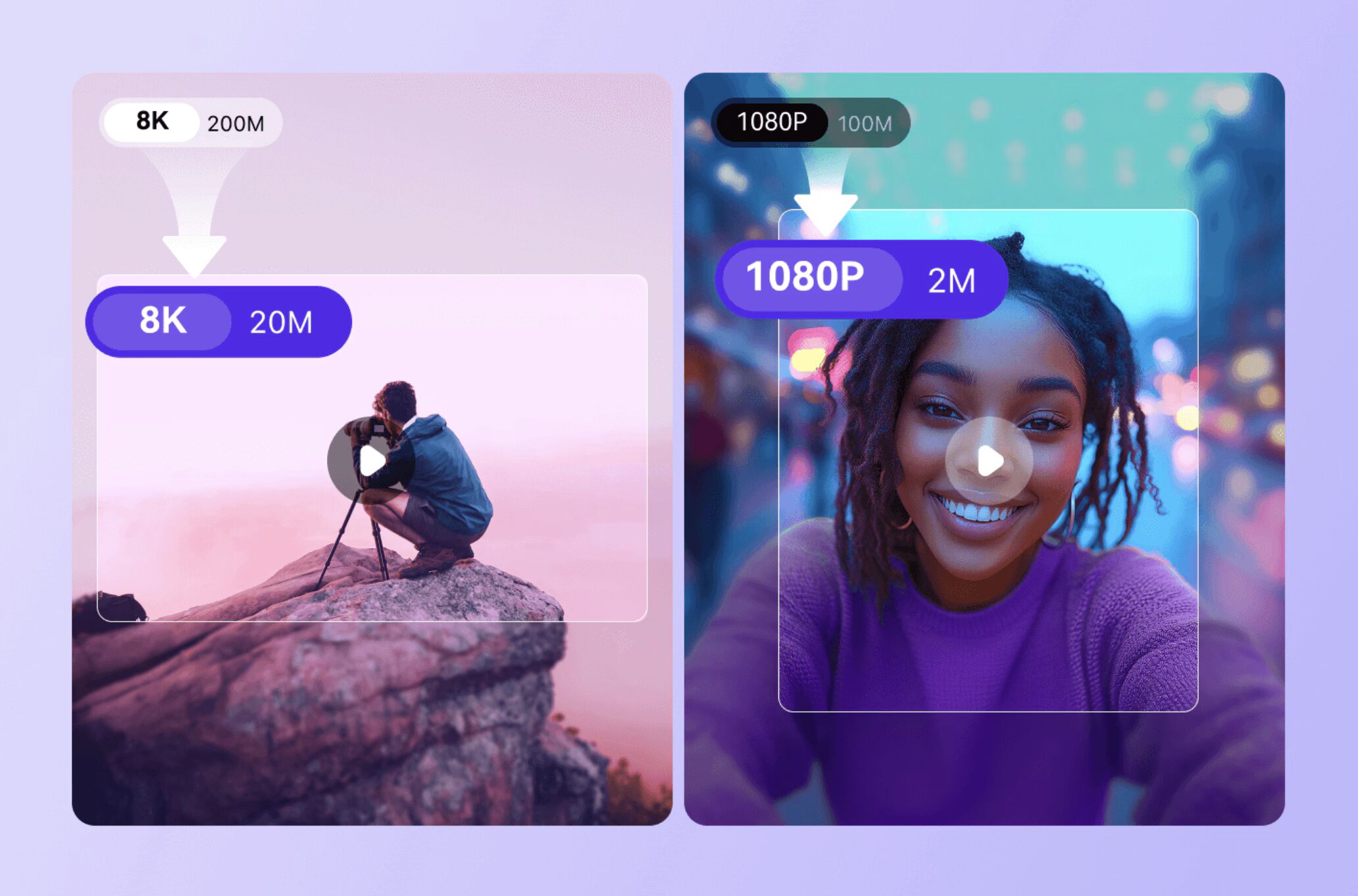

Netflix et Wondershare

Depuis 2017, Netflix utilise Dynamic Optimizer, son IA de compression adaptative, qui ajuste la qualité d’une vidéo image par image. L’algorithme s’appuie sur l’apprentissage automatique pour déterminer le meilleur niveau de compression pour chaque scène en fonction de son contenu. Le but ? Offrir une meilleure expérience de visionnage tout en réduisant la consommation de bande passante.

Aujourd’hui, cette technologie s’est popularisée. Wondershare, leader mondial de la conversion vidéo, propose depuis quelques mois UniConverter 16 qui inclut, entre autres services, la compression vidéo intelligente. La promesse est une réduction jusqu’à 150 % du poids original d’une capture. Bientôt, vous pourrez peut-être envoyer 30 min de vidéo 8K par e-mail et la télécharger en quelques secondes !

L’impact de la compression par l’IA

On réalise donc l’impact important que la compression par l’IA peut avoir sur la réduction des espaces de stockage et ses coûts inhérents (économique et écologique). On voit aussi l’amélioration apportée à la transmission des données : nous allons partager plus d’informations, plus vite, et de façon moins coûteuse.

Cet usage est surtout prometteur pour des secteurs comme la vidéosurveillance du trafic routier par exemple. Le domaine médical n’est pas en reste grâce à des évolutions comme :

- La réduction du poids des IRM en préservant les détails utiles au diagnostic.

- La diminution du nombre de pixels nécessaires au fonctionnement des implants rétiniens pour envoyer des informations pertinentes au cerveau.

Défis et limites

Si cette évolution est encourageante, elle fait encore face à des défis. La puissance de calcul nécessaire, le temps de traitement, l’accumulation d’erreurs lors de la décompression sont à considérer. Sans oublier la conception et la maintenance, plus complexes qu’avec les méthodes traditionnelles. L’adaptation des infrastructures et des équipes existantes reste donc à surmonter. Enfin, la consommation des ressources étant nettement plus élevée lors de l’utilisation de modèles IA, la réduction des coûts énergétiques fait certainement partie des améliorations à prioriser.

Que pensez-vous de ces progrès ? Êtes-vous dans le camp IA ou dans celui des méthodes traditionnelles ?